干貨滿滿,詳細(xì)解讀下一代HBM架構(gòu)!

轉(zhuǎn):

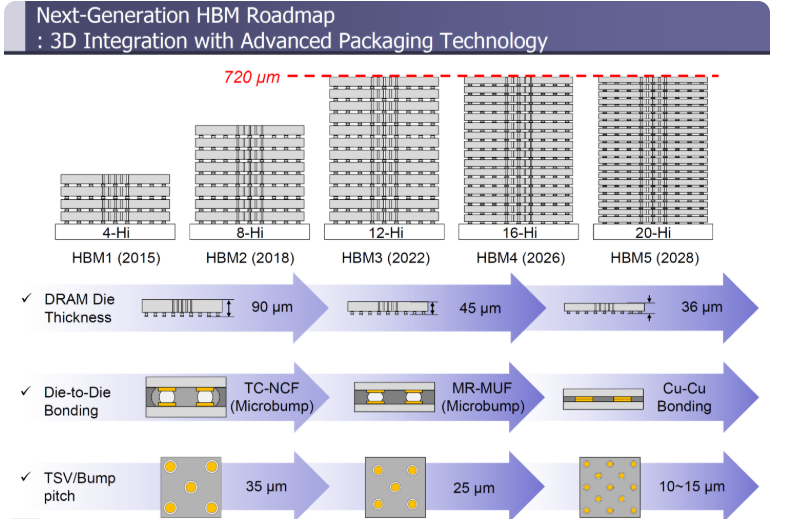

本文將詳細(xì)介紹下一代HBM標(biāo)準(zhǔn),包括HBM4、HBM5、HBM6、HBM7和HBM8,每一代都將提供巨大的進(jìn)步,以滿足不斷增長的數(shù)據(jù)中心和AI需求。

在韓國科學(xué)技術(shù)院(KAIST)和Tera (TB互連和封裝實驗室)最近的一份報告中,兩家公司概述了HBM的路線圖,并詳細(xì)介紹了對下一代標(biāo)準(zhǔn)的期望。該報告概述了幾個新的和即將推出的HBM標(biāo)準(zhǔn),如HBM4、HBM5、HBM6、HBM7和HBM8。

首先是HBM4。這將是2026年推出的下一代數(shù)據(jù)中心和AI GPU的首選標(biāo)準(zhǔn)。AMD和NVIDIA都已經(jīng)確認(rèn)在他們的MI400和Rubin產(chǎn)品中使用HBM。

這里也分享了些NVIDIA的路線圖,考慮到TeraByte負(fù)責(zé)處理HBM內(nèi)存的互連和封裝方法,這可能會有一些分量。

HBM4內(nèi)存用于NVIDIA的Rubin和AMD的MI500 GPU

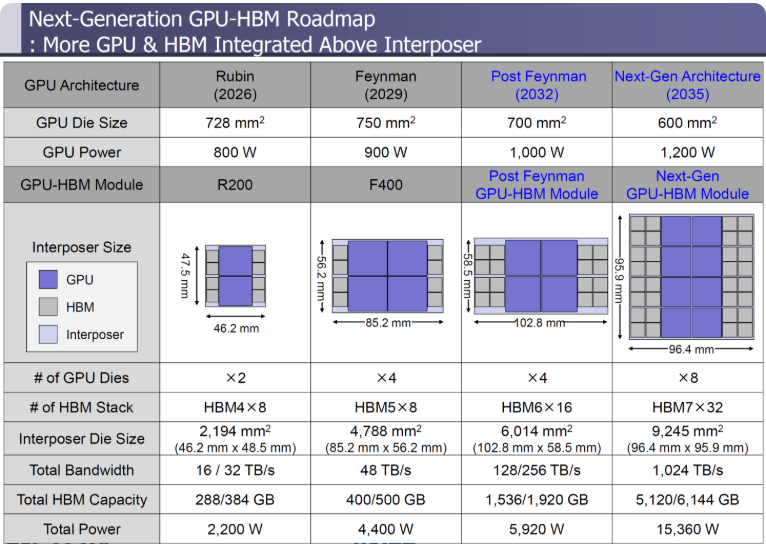

首先,我們看看NVIDIA的Rubin和Rubin Ultra,它們將分別利用HBM4和HBM4e內(nèi)存。在官方路線圖中,NVIDIA顯示Rubin有8個HBM4插槽,Rubin Ultra有16個HBM4插槽。每個都有兩個GPU芯片,但Ultra更大,提供標(biāo)準(zhǔn)Rubin的兩倍計算密度。

據(jù)該研究公司稱,Rubin的GPU芯片尺寸為728平方毫米,每個芯片將消耗800W的功率。這只是標(biāo)準(zhǔn)的Rubin產(chǎn)品。中間層的尺寸為2194 mm2 (46.2mm x 48.5mm),將承載288至384 Gb的VRAM容量,總帶寬為16-32 TB/s。芯片總功耗為2200W,幾乎是Blackwell B200 GPU的兩倍。

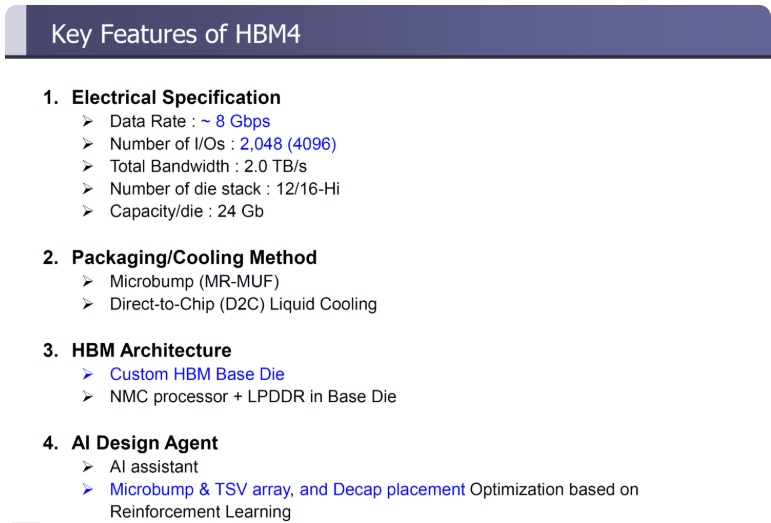

HBM4內(nèi)存標(biāo)準(zhǔn)的主要特性包括:

有趣的是,AMD的Instinct MI400也將于明年發(fā)布,與Rubin相比,它的性能更上一層,目標(biāo)是提供432Gb的HBM4容量,內(nèi)存帶寬高達(dá)19.6 TB/s。

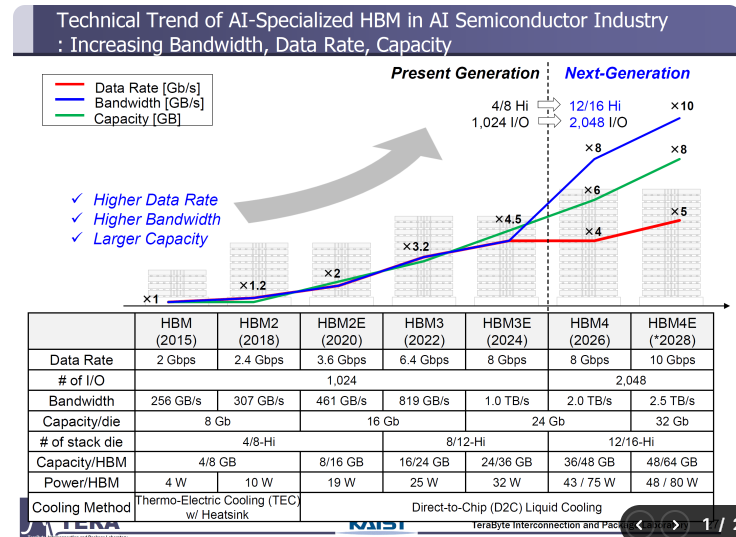

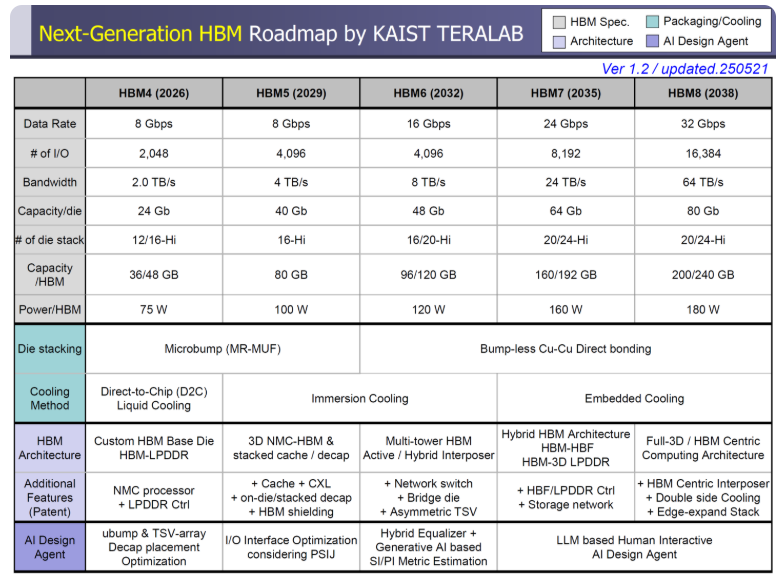

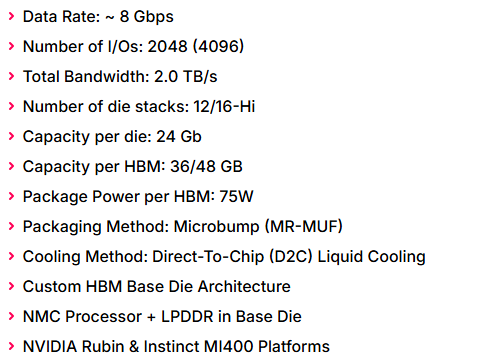

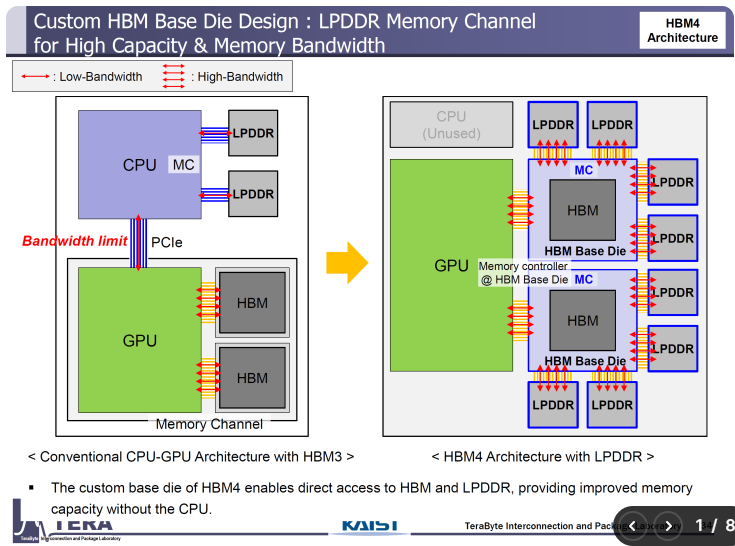

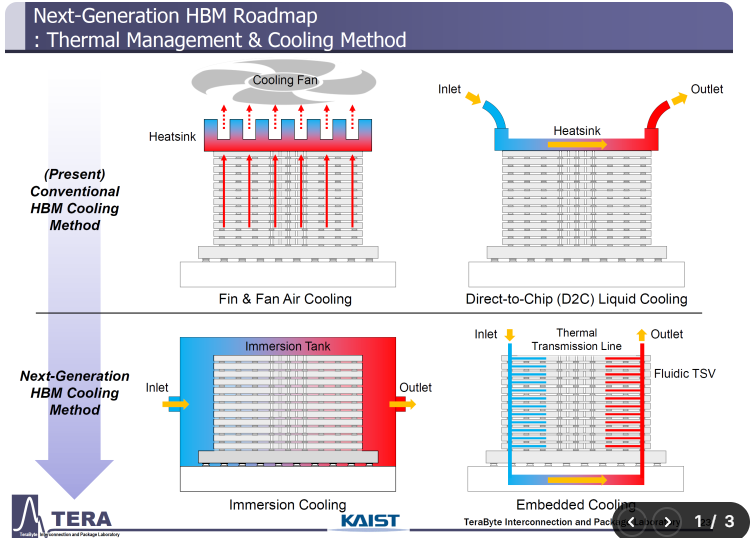

看看HBM4的細(xì)節(jié),目標(biāo)是提供8Gbps的數(shù)據(jù)速率,2048位IO,每堆棧的內(nèi)存帶寬為2.0 TB/s,每個die的容量為24Gb,內(nèi)存容量高達(dá)36- 48Gb,每堆棧功率封裝為75W。HBM4采用標(biāo)準(zhǔn)的D2C液體冷卻,并采用定制的基于HBM的芯片(HBM-LPDDR)。

HBM4e更進(jìn)一步,數(shù)據(jù)速率為10Gbps,每堆棧帶寬為2.5 TB/s,基于12-Hi和16-Hi堆棧,每個芯片容量高達(dá)32 Gb,內(nèi)存容量高達(dá)48/64 Gb,每個HBM封裝功率高達(dá)80W。

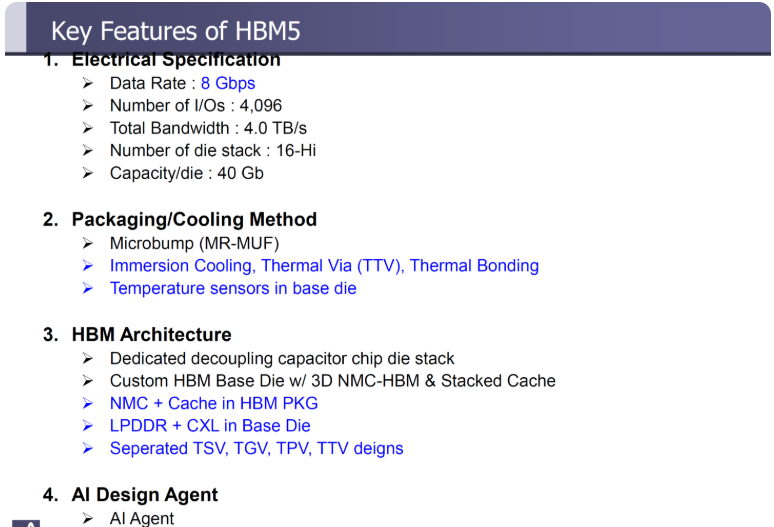

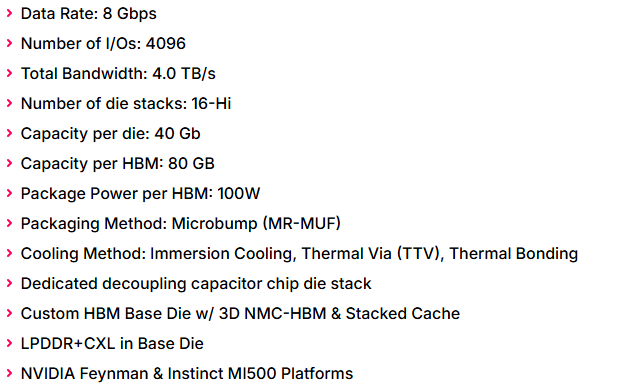

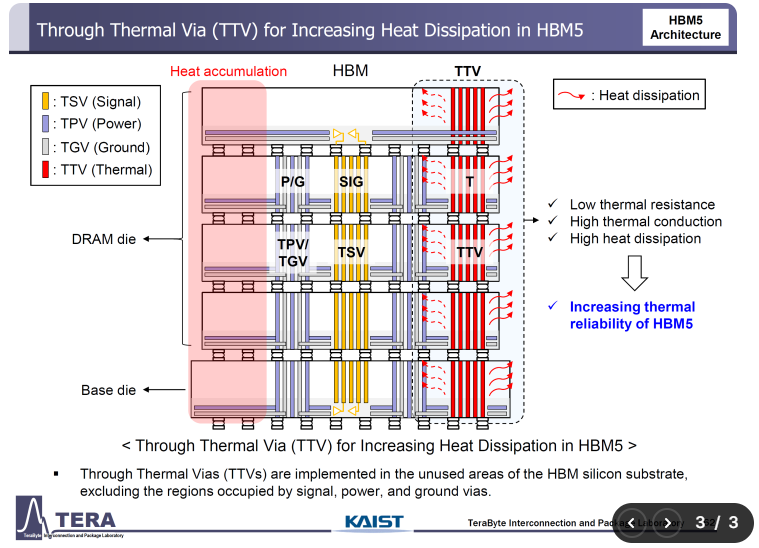

HBM5瞄準(zhǔn)NVIDIA Feynman,計劃于2029年上市

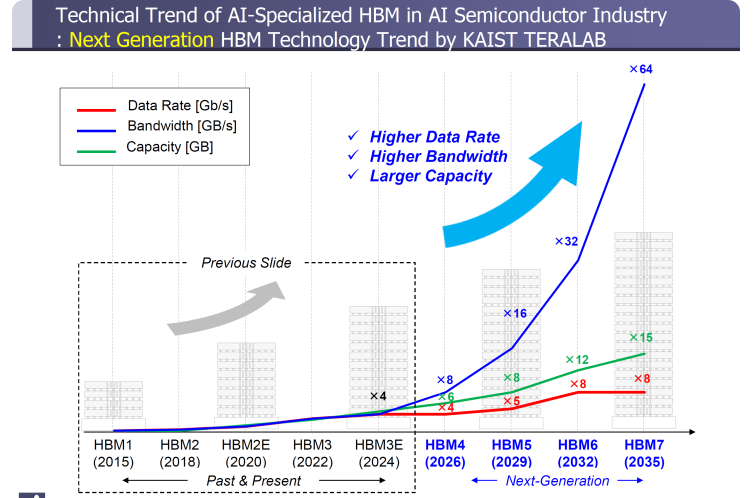

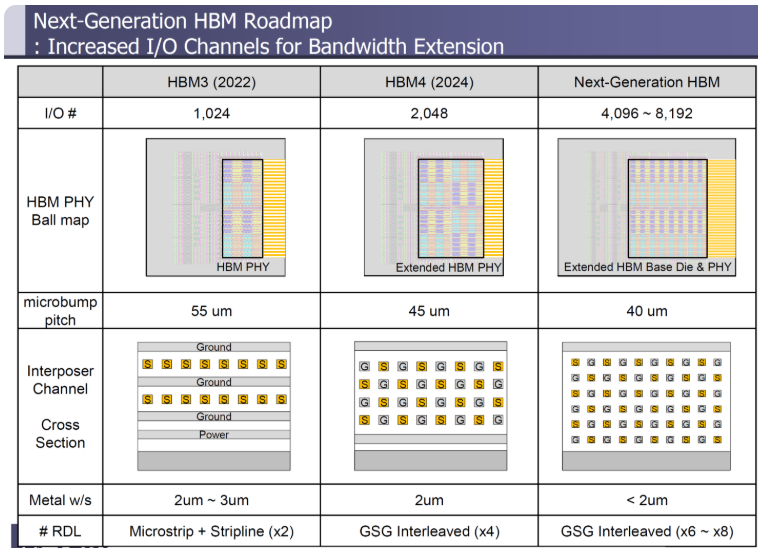

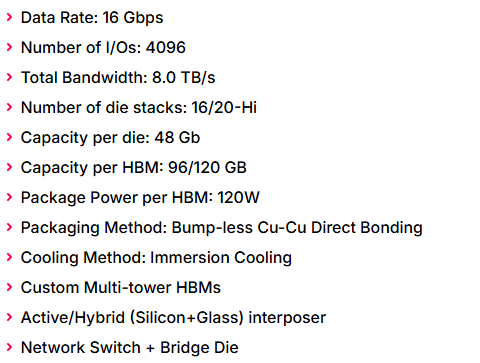

HBM5數(shù)據(jù)速率為8Gbps,驅(qū)動IO通道高達(dá)4096位。帶寬也增加到每個堆棧4TB /s,并將以16-Hi堆棧作為基準(zhǔn)。使用40 Gb DRAM芯片,HBM5將擴(kuò)展到每堆棧80 Gb的容量,每堆棧功率預(yù)計將達(dá)到100W。

HBM5內(nèi)存標(biāo)準(zhǔn)的主要特性包括:

NVIDIA的Feynman預(yù)計將成為第一款使用HBM5內(nèi)存標(biāo)準(zhǔn)的GPU,雖然NVIDIA列出了2028年的發(fā)布時間表,但看起來這家研究公司將基于生產(chǎn)和供應(yīng)周期的下一代解決方案定為2029年發(fā)布更為現(xiàn)實。

Feynman是一個750mm2的芯片GPU,每個芯片功率為900W,旗艦芯片將被稱為F400。英偉達(dá)沒有展示任何芯片本身的具體說明,但研究公司認(rèn)為它是一個帶有8個HBM5插槽的四GPU芯片封裝。據(jù)說這個封裝的尺寸為4788 mm2 (85.22mm x 56.2mm)。整個GPU應(yīng)該包含400- 500 Gb的HBM5,并將提供4400W的TDP。

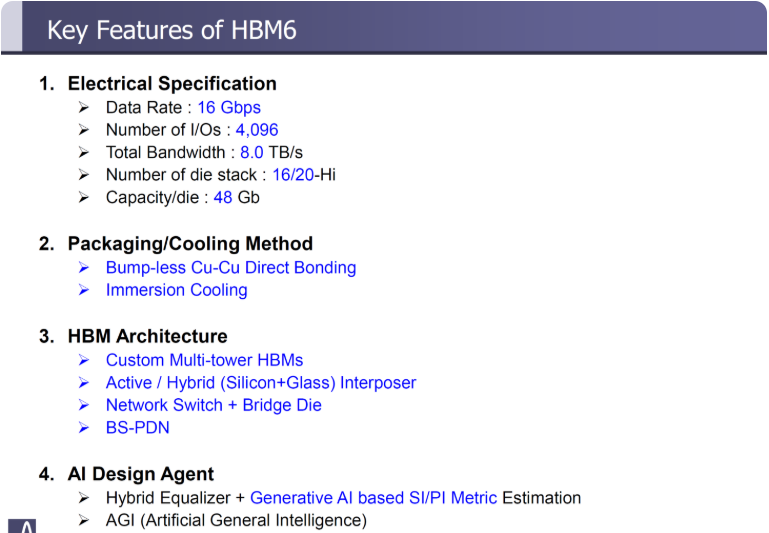

HBM6 Post-Feynman GPU架構(gòu)——巨大的功率、容量及帶寬

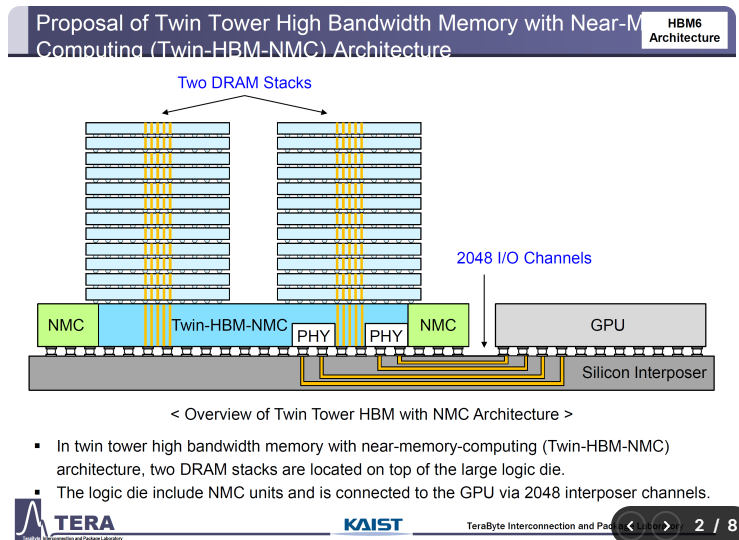

英偉達(dá)可能會推出更大的Feynman Ultra,但尚未上市。下面列出的是Post-Feynman時代的HBM6設(shè)計。在HBM6中,我們期望在使用4096位IO通道時看到16 Gbps數(shù)據(jù)速率。

HBM6內(nèi)存標(biāo)準(zhǔn)的主要特性包括:

HBM6的一個重大變化是,第一次看到HBM堆疊超過16-Hi到20-Hi,將每堆棧的內(nèi)存容量增加到96- 120GB,每堆棧功率為120W。

據(jù)該研究公司透露,每個GPU芯片尺寸為700平方毫米,每個芯片功率為1000W。該封裝將在6014 mm2 (102.8mm x 58.5mm)的封裝面積內(nèi)容納16個HBM6插槽,并將提供128-256 TB/s的帶寬,每個芯片的內(nèi)存容量為1536-1920 GB,總功率為5920W。這項技術(shù)預(yù)計將在2032年問世。

HBM7 & HBM8 ——為未來十年最大化內(nèi)存

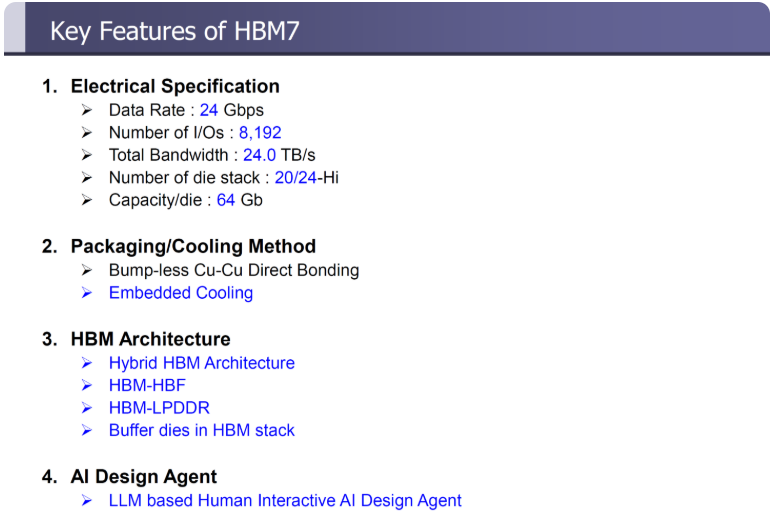

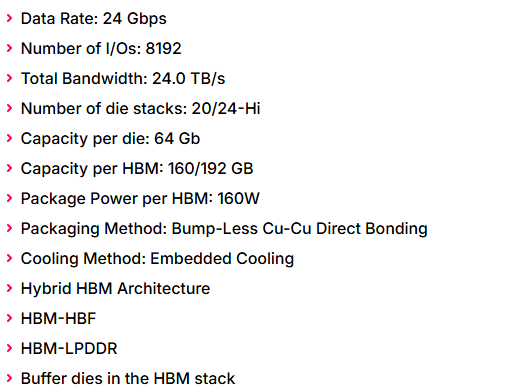

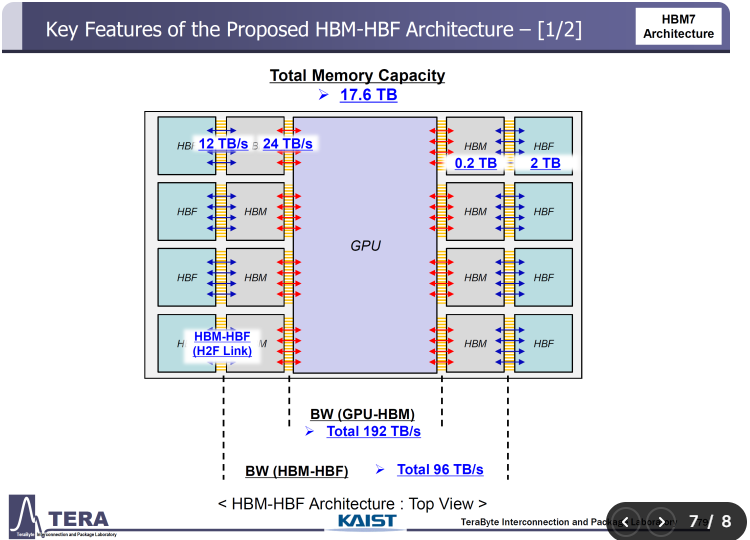

隨著HBM6成為下一個十年開始的亮點(diǎn),HBM7和HBM8將成為將標(biāo)準(zhǔn)提升到全新水平的大炮。HBM7將提供每堆棧24 Gbps的引腳速度和8192個IO通道,是HBM6的兩倍。增加的數(shù)據(jù)速率和IO能力將把帶寬提高到24 TB/s,是HBM6的3倍,并且每個DRAM芯片的容量為64 Gb,由于20-24-Hi的內(nèi)存堆棧,將看到每個堆棧的容量高達(dá)160-192 GB。每個堆疊的封裝功率為160W。

HBM7內(nèi)存標(biāo)準(zhǔn)的主要特性包括:

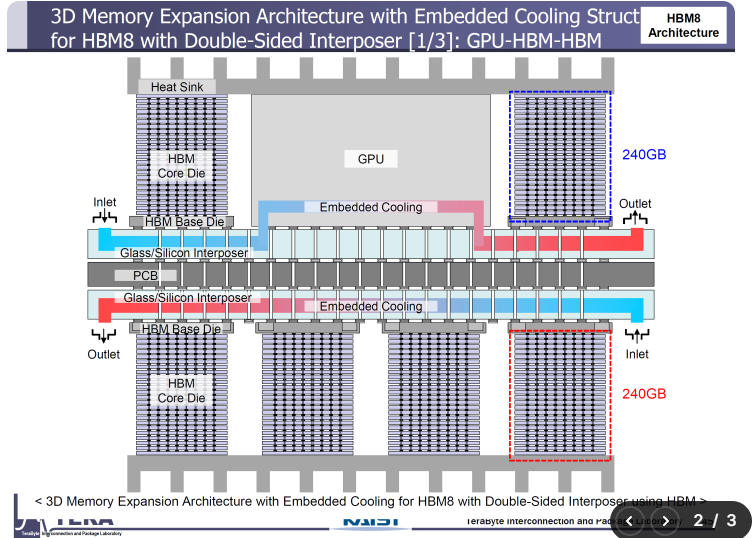

HBM6,HBM7和HBM8的die堆疊將使用無碰撞Cu-Cu直接鍵合實現(xiàn),HBM7/HBM8將采用嵌入式冷卻解決方案。HBM7還將推出全新的HBM-HBF和HBM-3D LPDDR架構(gòu)。

基于HBM7內(nèi)存的下一代解決方案預(yù)計將變得超大和多chiplet,一個封裝提供8個GPU插槽,每個GPU的尺寸為600 mm2,功耗高達(dá)1200W,而32個HBM7插槽提供1024 TB/s的帶寬,使其成為第一個PB級帶寬解決方案。該芯片還應(yīng)該包含高達(dá)5120- 6144 GB的巨大內(nèi)存容量,預(yù)計總功率為15,360W,幾乎是基于HBM6解決方案的3倍。

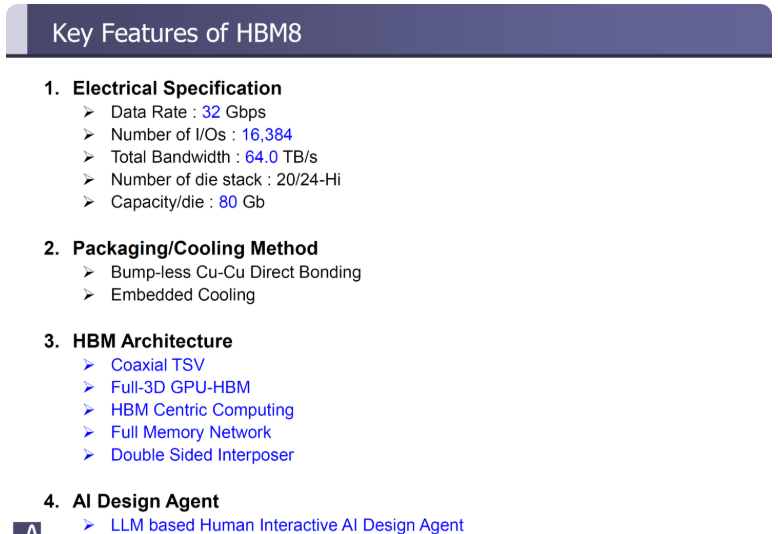

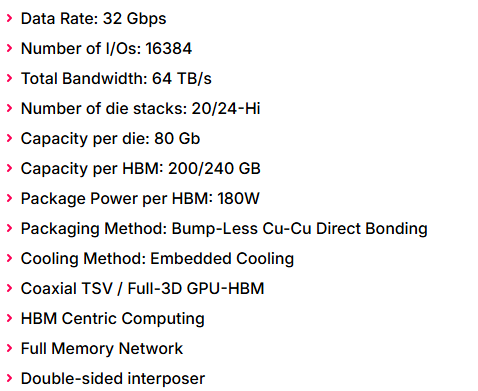

HBM8內(nèi)存標(biāo)準(zhǔn)的主要特性包括:

對于HBM8來說,內(nèi)存標(biāo)準(zhǔn)要到2038年才會到來,所以還有很長的路要走,但預(yù)期的規(guī)格包括32Gbps的數(shù)據(jù)速率和加倍的IO通道,達(dá)到16384。內(nèi)存解決方案將提供每個堆棧64 TB/s的帶寬,每個DRAM的容量為80 Gb,高達(dá)200/240 GB的內(nèi)存容量和每個HBM插槽的封裝功率高達(dá)180W。

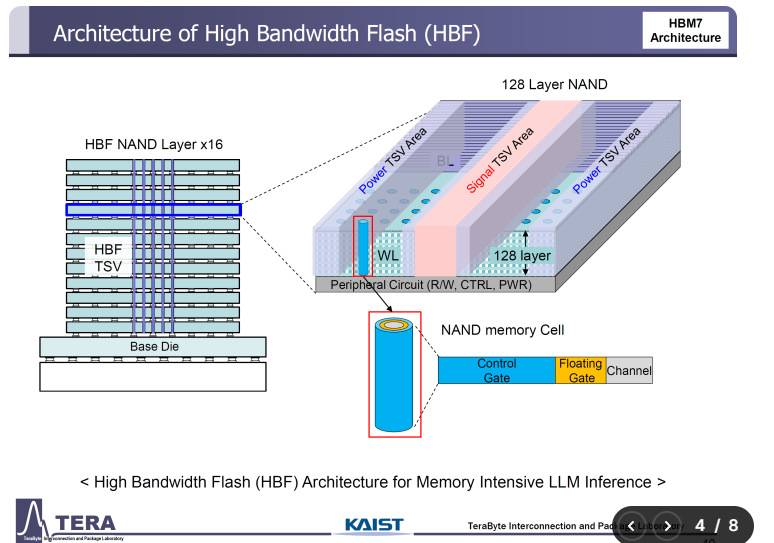

用于內(nèi)存密集型LLM推理的HBF架構(gòu),創(chuàng)新的冷卻方法

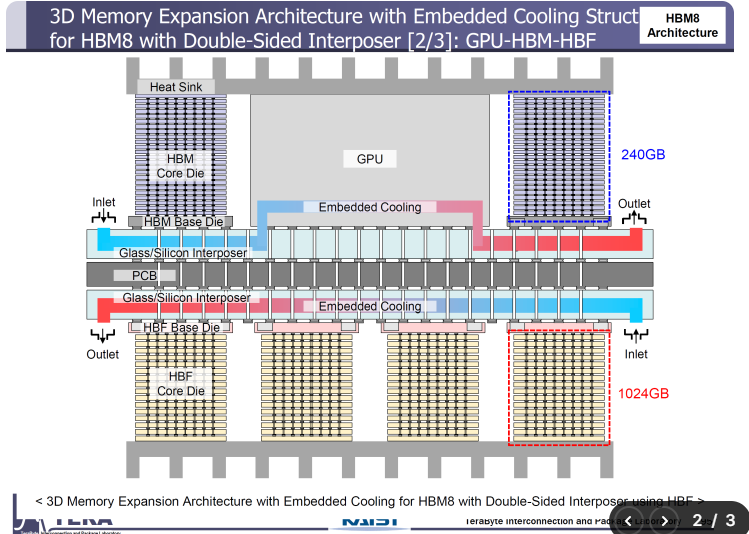

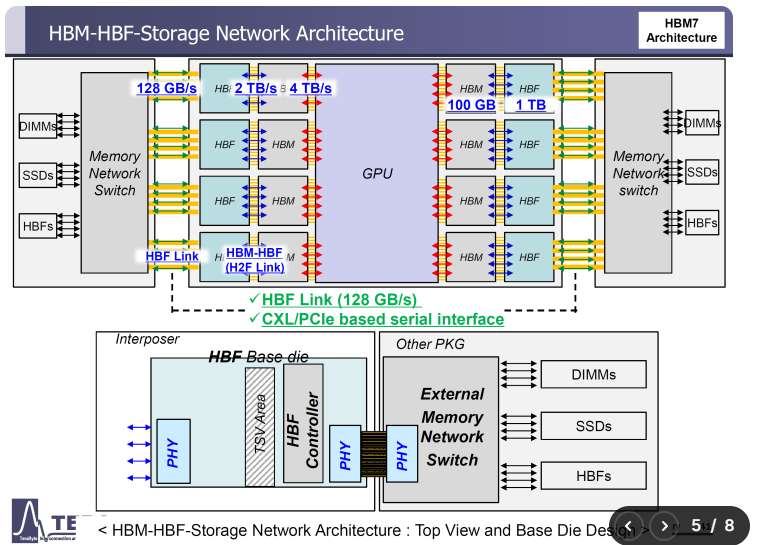

還有一件事是HBF架構(gòu),它的設(shè)計是為了滿足內(nèi)存密集型LLM推理的需求。對于HBF,制造商不再使用標(biāo)準(zhǔn)的內(nèi)存DRAM,而是使用NAND,最高可達(dá)128層,在16-Hi堆棧中提供更高的容量,并使用HBF TSV解決方案進(jìn)行互連。

每個HBF堆棧與HBM堆棧并行連接,并且能夠提供高達(dá)1TB的額外容量,并使用快速的2TB /s HBM-HBF互連,該互連使用通過內(nèi)存網(wǎng)絡(luò)交換機(jī)運(yùn)行的128 GB/s雙向互連與主板上的其他組件通信。

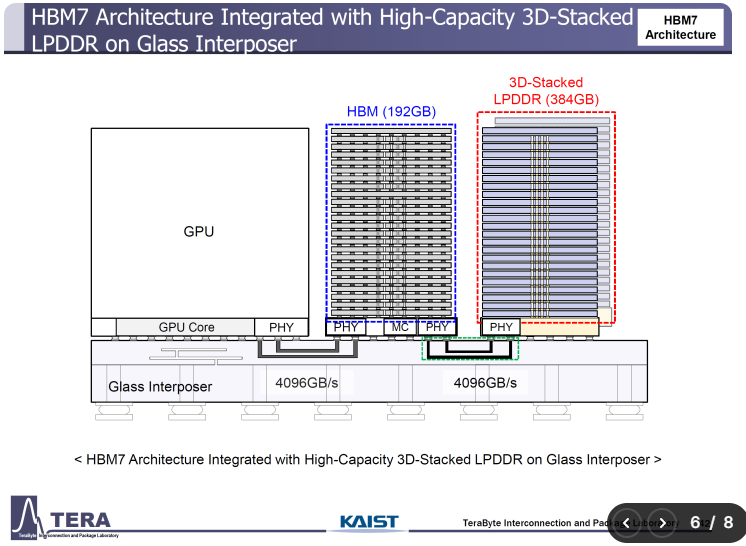

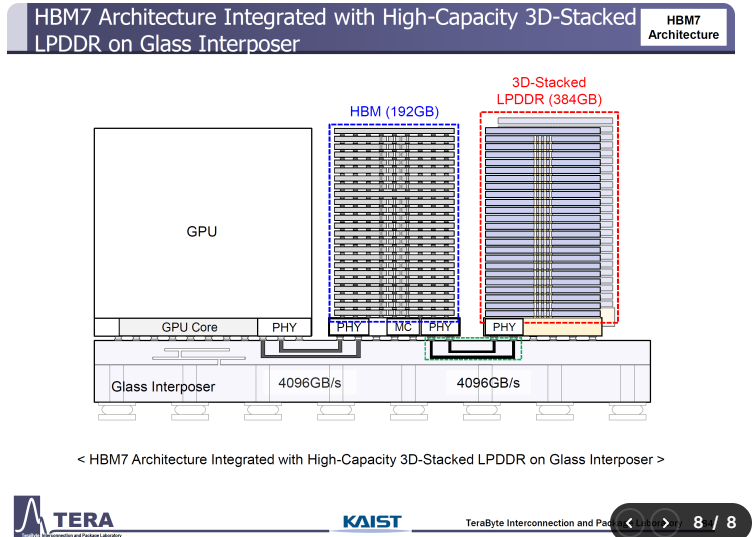

在HBM7中,這種基于NAND的堆棧進(jìn)一步升級,并使用提供4096 GB/s傳輸速度的互連連接到玻璃中間層。容量高達(dá)384 GB的LPDDR解決方案與容量為192 GB的HBM堆棧一起運(yùn)行。

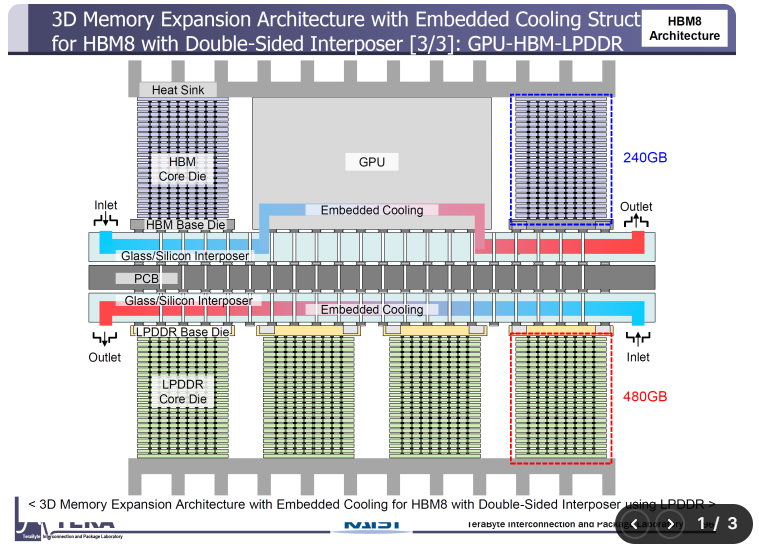

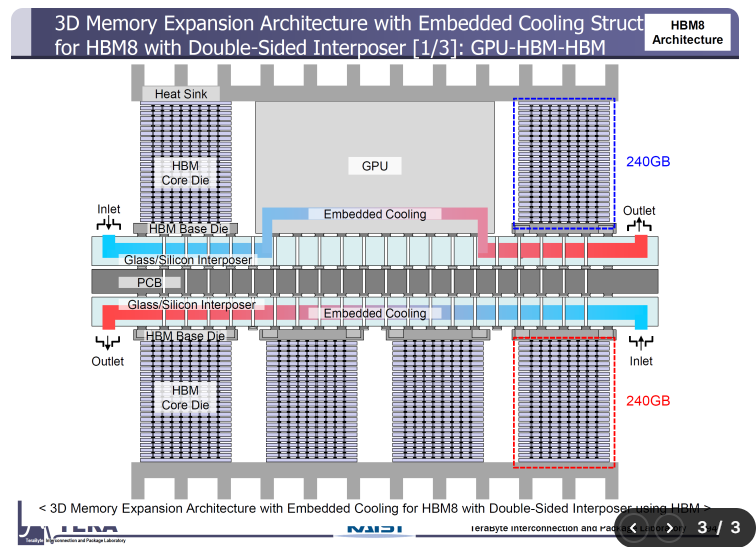

HBM堆棧也將擴(kuò)展到24-Hi設(shè)計,在雙塔高帶寬封裝中使用HBM7和HBM8。

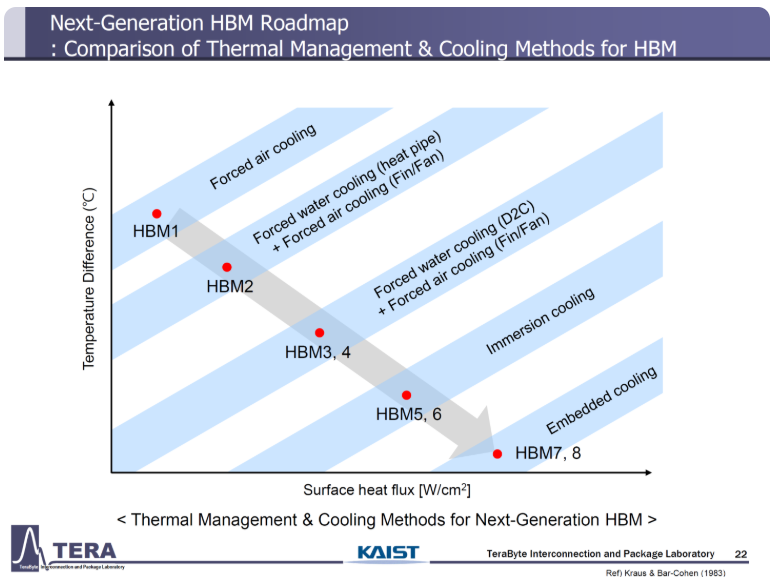

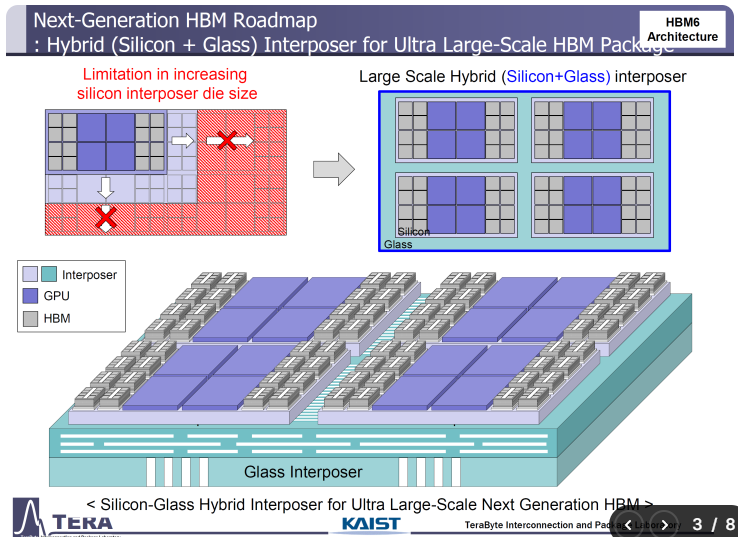

隨著基于玻璃的硅中間層的到來,該研究公司強(qiáng)調(diào)使用嵌入式冷卻作為標(biāo)準(zhǔn)方法,它將通過中間層并為HBM, HBF和GPU IP提供直接冷卻。